Imaging el futuro

Érase una vez, la inspección visual de la infraestructura submarina significaba que los buzos llevaban cámaras fotográficas al fondo marino, esperando que la carcasa de la cámara no se inundara, o que la película no estuviera sobre expuesta o destruida durante el desarrollo. Incluso usando los primeros vehículos operados por control remoto (ROV) con una transmisión de video en vivo, fue difícil observar lo suficiente un objetivo de inspección, debido al control limitado y la funcionalidad de posicionamiento si existiera algún nivel de corriente.

Es seguro decir que la industria ha avanzado mucho desde entonces y las posibilidades de imágenes se están expandiendo día a día. De hecho, el problema ahora se está convirtiendo en cómo procesar el "tsunami" de los datos que se están recopilando.

Estos temas fueron los principales de la agenda en un seminario conjunto organizado por la Sociedad Hidrográfica de Escocia (THSiS), la Asociación Internacional de Contratistas Marítimos (IMCA) y la Sociedad de Tecnología Subacuática (SUT) en Aberdeen en octubre.

Por un lado, las plataformas de sensores están evolucionando. Tanto los ROV como los vehículos submarinos autónomos (AUV) son cada vez más rápidos de usar; BP tiene el objetivo de que el 100% de la inspección submarina se realice a través de los sistemas autónomos marinos (MAS) para el año 2025, dijo Peter Collinson, especialista sénior y ambiental en BP en la petrolera, en el seminario.

También se están volviendo más autónomos, apoyados por centros de operaciones en tierra. Equinor ya ha probado las operaciones piloto de ROV desde centros en tierra (a través de Oceaneering y IKM) y este año está programado para probar el robot submarino de Eelume en un garaje submarino en el campo de Åsgard, en la costa de Noruega, en una tether. Para el año 2020, se espera que se vaya sin ataduras, dijo al seminario Richard Mills, director de ventas, Kongsberg Maritime Robotics. El siguiente paso podría usarse en combinación con buques de superficie no tripulados.

Mientras tanto, las tecnologías de imágenes, desde láser a fotogrametría, están ayudando a estas plataformas a recopilar más datos, más rápido y, potencialmente, también a ayudarlos a navegar.

Operaciones de levantamiento submarino utilizando un sistema ORUS3D. (Fuente: Comex Innovation)

Operaciones de levantamiento submarino utilizando un sistema ORUS3D. (Fuente: Comex Innovation)

Bonitas - medibles - imágenes

Sobre la marcha se realizan encuestas mediante fotogrametría. En el verano de 2018, Comex Innovation completó dos proyectos de inspección costa afuera del Mar del Norte utilizando su tecnología de fotogrametría submarina ORUS3D, habiendo realizado proyectos en África Occidental, dijo Raymond Ruth, Reino Unido y Agente del Mar del Norte para la Innovación Comex. Ambas operaciones, en el Reino Unido y en los sectores daneses del Mar del Norte, requerían mediciones de alta precisión, una en apoyo de las modificaciones de zonas industriales abandonadas.

El sistema óptico submarino ORUS3D mide y luego crea modelos 3D de alta resolución de estructuras submarinas. Cada sistema comprende un haz integrado de sensores trifocales, con cuatro unidades de flash LED de haz ancho, más una unidad de adquisición y procesamiento de datos. Utiliza la triangulación de características dentro de las imágenes capturadas para localizar su posición relativa y construir una reconstrucción de nube de puntos 3D que se puede usar para la medición, de modo que no se necesita un sistema de navegación inercial o una ubicación de destino en el objeto para el escalamiento cuando se encuentra en el sitio.

La unidad integrada se adapta a un ROV para la adquisición de datos de vuelo libre a más de 40 cm de distancia de las estructuras, aunque la mejor distancia es entre 1 y 2 m del objeto. Esto no toma más tiempo que una encuesta general de video, dijo Ruth.

El procesamiento inicial en tiempo real a bordo se lleva a cabo para evaluar la ubicación y la calidad, antes del procesamiento en el sitio (en la embarcación de soporte), para verificar la calidad de los datos y crear un modelo 3D de escala inicial con una precisión de cm. El procesamiento final de los datos, que se recopilan como datos de nube de puntos, se lleva a cabo para reconstruir el sitio u objeto en un modelo 3D con una precisión de mm.

Resultados de una encuesta ORUS3D (Fuente: Comex Innovation)

Resultados de una encuesta ORUS3D (Fuente: Comex Innovation)

Eventos automatizados

EIVA ha estado trabajando en el uso de técnicas de aprendizaje automático y de visión por computadora para detectar objetos como ánodos en tuberías, daños en tuberías y crecimiento marino de forma automática, utilizando una cámara convencional, dijo Matthew Brannan, topógrafo senior, EIVA. Utilizar el aprendizaje automático significa tener que entrenar un sistema con decenas de miles de imágenes de tuberías. Esto es lo que EIVA ha estado haciendo, y está dando frutos. La compañía ha realizado pruebas con los conjuntos de datos existentes que se realizaron de la manera tradicional, por lo que fue posible comparar los resultados automatizados con los eventos hechos por el hombre. A fines de 2018, también comenzó las pruebas en vivo durante las operaciones basadas en ROV. El objetivo final de la tecnología es el reconocimiento automático de eventos durante una encuesta de AUV, lo que permite que un AUV detecte algo y luego envíe un mensaje a un barco de superficie, dijo Brannan.

EIVA también está llevando las cámaras convencionales, utilizando la ubicación y el mapeo simultáneos (SLAM) y la fotogrametría para hacer áreas del mapa, al mismo tiempo que puede ubicar la posición de la cámara en relación con lo que está mapeando. Los sistemas SLAM existentes se basan en el cierre de bucle y las soluciones de fotogrametría requieren una gran cantidad de superposición de imágenes y buena visibilidad, y generalmente no son en tiempo real, explicó Brannan. Algunos también confían en las costosas cámaras estéreo, que necesitan calibración y ocupan espacio, dijo.

EIVA llama a su sistema VSLAM, o SLAM visual. Al crear una nube de puntos dispersos sobre la marcha, VSLAM puede ubicarse (es decir, el vehículo en el que se encuentra) en su entorno y usar el modelo que está creando para rastrear y escanear automáticamente las estructuras submarinas. Esto es posible con una sola cámara, dijo Brannan, y a partir de imágenes fijas o imágenes extraídas del video, mediante el seguimiento de puntos en cada imagen y la estimación de una pista, utilizando esos puntos, para construir la nube de puntos dispersos, creando un modelo de terreno digital. Una AUV también sabría su posición absoluta original y luego podría usar puntos de referencia (es decir, puntos de referencia) a lo largo de la ruta.

La nube de puntos se puede usar para crear una nube de puntos 3D densa y luego una malla, con color y textura agregados. EIVA ha tenido un equipo trabajando en esto desde 2017 y ahora está probando el sistema en AUV. Este año, se ejecutarán proyectos en vivo, con navegación visual, dijo Brannan, y luego de eso quiere ayudar a la inspección autónoma y la intervención ligera.

SUBSLAM

Rovco tiene la visión de implementar un AUV con un vehículo de superficie autónomo (ASV) para realizar levantamientos y mapeo con su tecnología de mapeo e imagen 3D en vivo SubSLAM. SubSLAM permite que un ROV construya un mapa 3D de su entorno sobre la marcha, sin utilizar otros sistemas de navegación o posicionamiento inerciales. La firma lo llama visión por computador 3D en vivo.

El concepto de SubSLAM en vivo de Rovco (Fuente: Rovco)

El concepto de SubSLAM en vivo de Rovco (Fuente: Rovco)

La tecnología de cámara inteligente SubSLAM X1 de Rovco utiliza un sistema de doble cámara para crear una nube de puntos en vivo de lo que ve. Esto se usa para calcular la posición del vehículo en relación con lo que está mirando.

Rovco ha estado utilizando SubSLAM en un ROV de observación de Mojave subatlántico, pero lo está haciendo compatible con otras plataformas, dijo Joe Tidball. La firma planea adquirir su primer AUV, un Sabertooth, de Saab Seaeye, este año, integrando SubSLAM en 2020, y luego incorporando inteligencia artificial (AI) al sistema en 2021. Luego, busca realizar encuestas desde un ASV desde 2022.

Tidball dijo que el sistema es adecuado para la metrología submarina y podría usarse con un vehículo sin cable que utilice comunicaciones acústicas, conectado a una pasarela de comunicaciones de superficie con redes de radio / celular o satélite y luego a la nube, donde los ingenieros podrían acceder a una herramienta de medición basada en el navegador. - siendo alimentado con datos en vivo en 3D. Con la IA, el vehículo podría hacer evaluaciones por sí mismo.

Rovco probó su sistema SubSLAM en la catástrofe de energía renovable en alta mar en Blyth, noreste de Inglaterra, en agosto de 2018. Tidball dijo que la compañía probó la precisión de la medición que podía lograr utilizando datos de levantamientos terrestres en estructuras en un dique seco, que luego se inundó, por lo que SubSLAM podría Hacer su trabajo en visibilidad de 1,2 m. Los datos bajo el agua se compararon con un escáner láser. En comparación con las dos horas tomadas para realizar un levantamiento al aire libre, con un error de alineación de 1,7 mm, SubSLAM logró un error de 0,67 mm, a partir de un escaneo de dos minutos, dijo Tidball.

Tidball dijo que el sistema podría anular la necesidad de sistemas de línea de base larga (LBL), para la precisión de posicionamiento, pero dijo que la visibilidad era un factor para que las cámaras funcionen. Si bien la tecnología es capaz de ubicar el ROV o AUV dentro de su entorno, si se estaba moviendo a otro sitio y no tenía cable, sería necesaria la navegación inercial.

Regreso al futuro

Las técnicas utilizadas para crear nubes de puntos sobre la marcha también se pueden usar para crear nubes de puntos a partir de imágenes o secuencias de video existentes, dijo el Dr. Martin Sayer, director gerente de Tritonia Scientific, con sede en Escocia. Como ejemplo, Tritonia utilizó su tecnología como parte de un análisis de beneficios ambientales netos de una chaqueta de plataforma en un lugar tropical, donde un operador quería determinar cuánto peso extra agregaría el crecimiento marino a una chaqueta, para los cálculos de operaciones de elevación y la eliminación en tierra. planificación. Tritonia recibió imágenes existentes de ROV para evaluar. Esto se había tomado para estudios de vida de peces, no para bioincrustaciones de chaqueta, por lo que no fue diseñado ni diseñado para modelado 3D. Dos cámaras HD y una cámara estándar habían sido montadas en el ROV, izquierda, derecha y central.

Debido a la luz en el agua y la mayoría de las imágenes dirigidas a los peces, alrededor del 95% no fue utilizable. El resto fue filmado en la noche, lo que lo hace más adecuado, sin interferencias en la superficie y mejor contraste, lo que permite modelar una sección casi completa de la pierna. Al eliminar el volumen de pierna conocido del modelo, se puede calcular el volumen de crecimiento marino.

Sobre la marcha

Para algunos, el potencial real de toda esta tecnología es poder procesar datos en vivo y usar esa información para retroalimentar sistemas autónomos en vivo (aunque supervisados).

Hay un circuito de retroalimentación que hará que estas operaciones sean más poderosas. "Procesar los datos [que recopilamos] automáticamente es cuando obtenemos valor", dijo Nazli Deniz Sevinc, líder del proyecto uROV, OneSubsea. "Además, [es] un circuito de retroalimentación en los algoritmos de autonomía supervisados y la detección de características", como comentó Brannan.

Mucho está pasando. La autonomía supervisada, la detección autónoma de fallas, las operaciones no tripuladas, sin la necesidad de embarcaciones de apoyo, son el objetivo. Hay obstáculos, como la legislación, que en el área de los sistemas de buques no tripulados está detrás de la tecnología disponible. Hay problemas con los estándares de datos y cómo manejar la cantidad de datos que se están creando, y no solo para adaptar estas técnicas a los flujos de trabajo de hoy (o adaptar los flujos de trabajo en sí mismos). Es un espacio de movimiento rápido para ver con una gran cantidad de límites borrosos (si no imágenes).

Tsunami de datos

Las nuevas tecnologías de imagen están creando nuevas oportunidades para la visualización submarina y la autonomía. También están creando un desafío de "tsunami de datos" para los operadores. Peter Collinson, de BP, dijo: "Una de las mayores preocupaciones es (que) cuando empieces a enviar flotas de AUV por ahí, tendremos un tsunami de datos llegando a nosotros. Nos hemos centrado en las plataformas [de sensores / encuestas], porque todavía estamos creando confianza en lo que son estos sistemas y en lo que pueden hacer. La pieza de datos está llegando ... tratando con esos datos de manera oportuna. ¿Cómo formamos un gemelo digital y llegamos a la detección automática de cambios predictivos y de series de tiempo? "

Si bien la recopilación de datos evoluciona rápidamente, el enfoque futuro está en la entrega de datos a las personas que lo necesitan, como los ingenieros de tuberías, en un formato que sea significativo y útil. La inteligencia artificial (IA) ayudará, dijo Malcolm Gauld, de Fugro, a través del uso de la computación en la nube y la detección automática de anomalías o defectos. Pero llevará tiempo desarrollar sistemas, dijo. Fugro está trabajando en esto y ha realizado pruebas en Perth, que han ayudado a plantear problemas con la IA, como diferenciar un revestimiento plateado de un tiburón. Los pasos futuros incluyen la construcción de autonomía en esa IA. Pero, Gauld sugirió que los nuevos modelos también deberían ser vistos. Se podría construir tuberías con sensores, haciéndolo "inteligente" desde el principio con todo el mantenimiento predictivo, preguntó. "En el futuro no se tratará de qué equipo usa para obtener esa información, sino de lo que obtiene de esa información".

De hecho, en el futuro, ni siquiera estaremos viendo estos datos, sugirió Joe Tidball, topógrafo senior de Rovco. Inteligencia artificial, robótica, hará la interpretación y toma de decisiones. “No creo que en 10 años estemos viendo más el video. Simplemente recibiremos informes de robots en el Mar del Norte que nos indiquen que debe consultar XYZ ".

Inspección rápida de tuberías

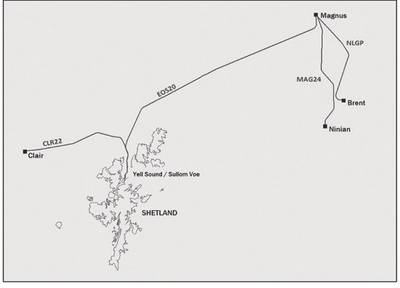

Para las encuestas de tuberías, BP se ha centrado en hacer las cosas más rápido. En 2017, BP contrató a DeepOcean, utilizando un "ROV rápido" (foto superior, ROV superior de Kyst Design de Noruega) para inspeccionar 478 km de ductos (mapa abajo), entre las instalaciones de Clair y Magnus en el Mar del Norte hasta la Terminal de Sullom Voe, en la costa Shetland, y desde las instalaciones de Brent y Ninian hasta Magnus, todo en poco menos de cuatro días. La encuesta incluyó láser, cámaras fijas de alta definición y sistemas de inspección de protección catódica (CP) con gradiente de campo de Force Technology (FIGS), y un promedio de tiempo de inspección de 5,1 kt / hora, 6 veces más rápido que un ROV estándar y 5 veces más rápido que un ROV estándar modificado, dijo Collinson . También incluía datos de exploración lateral y de levantamiento multihaz. El resultado final fue un archivo de capa de escena 3D, un mosaico georreferenciado 2D y listados de eventos / anomalías.

Un diseño superior de Kyst ROV se está implementando para la encuesta de tuberías de BP por DeepOcean (Fuente: BP)

Un diseño superior de Kyst ROV se está implementando para la encuesta de tuberías de BP por DeepOcean (Fuente: BP)

El sistema de tuberías analizado durante cuatro días (Fuente: BP)

El sistema de tuberías analizado durante cuatro días (Fuente: BP)

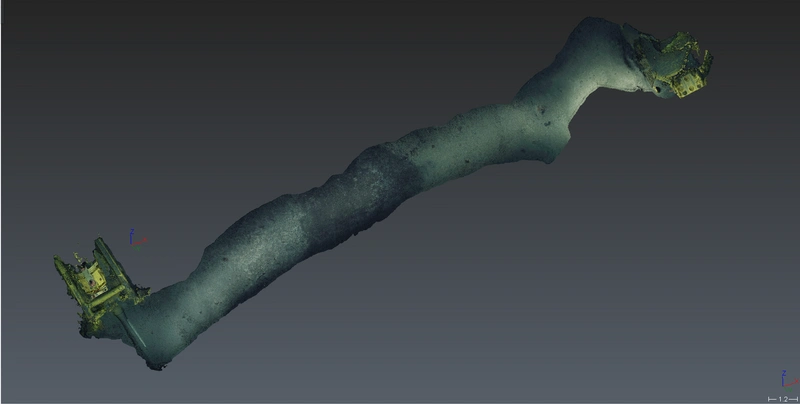

Una sección del oleoducto en la encuesta (Fuente: BP)

Una sección del oleoducto en la encuesta (Fuente: BP)

Estiramiento acústico

La empresa de Schlumberger OneSubsea está trabajando en un proyecto llamado uROV. Su objetivo es un vehículo submarino residente sin ataduras, con autonomía supervisada, lo que significa poder comunicarse por video con el vehículo desde la costa. Pero, mientras que las redes móviles 4G disponibles en alta mar se están abriendo a través de la comunicación por video a través del aire, los enlaces de video por agua no son tan fáciles, dijo Nazli Deniz Sevinc, líder del proyecto uROV, OneSubsea, a la Society of Underwater Technology (SUT), International Marine Seminario conjunto de la Asociación de Contratistas (IMCA) y la Sociedad Hidrográfica de Escocia (THSiS) en octubre.

El programa uROV de OneSubsea planea usar un vehículo Saab Seaeye Sabertooth, montado con las tecnologías Schlumberger. La visión de uROV se encuentra en algún lugar entre un AUV y un ROV operado manualmente, que ofrece autonomía sin ataduras pero supervisada, dijo Sevinc. Esto implicaría tener un "humano en el bucle", mientras trabaja a distancias de hasta 3 km desde una pasarela de comunicaciones de superficie, por ejemplo. Una superficie no tripulada. Cuando se encuentre cerca de una infraestructura submarina, también tendrá un enlace de datos de hasta 200 m a través del agua.

Esto permitiría el acceso a vehículos submarinos 24/7. Pero, significa que se necesita wi-fi submarino, detección avanzada, detección visual, control avanzado y análisis automático. Sevinc dijo que la uROV usaría EIVA Navisuite, para la planificación de la misión, y una capa de autonomía desarrollada para el Sabertooth. Pero, esto se basa en la retroalimentación en tiempo real, que se basa en las comunicaciones.

Para las operaciones en zonas industriales abandonadas, uROV ha estado apuntando a las comunicaciones acústicas, lo que inherentemente significa una baja velocidad de datos. OneSubsea, a través de su base en Boston, Schlumberger, ha estado trabajando en la cantidad de datos que puede comprimir a través de 100kpbs. En 2017, Sevinc dijo que la empresa logró la transferencia de video de barco a barco a través de un canal acústico a 100kbps en 1 km. Entonces logró resultados similares con una transferencia vertical. Sevinc dijo que este es un límite superior para el video, y que el ancho de banda restante se usa para los comandos. A lo largo de 2018, esta capacidad se integró en la uROV, con planes para desarrollar la capacidad de transferir datos de video a lo largo de 3 km este año y las implementaciones reales para fines de año. Otro kit que se está integrando en el uROV incluye la tecnología láser LiDAR (detección de luz y rango) desde 3D a profundidad.

-167623)

-167415)

-167309)

-167178)

-166941)

-166725)